?近期,,實驗室碩士研究生段士童作為第一作者的論文“Negating Negatives: Alignment with Human Negative Samples via Distributional Dispreference Optimization”被Findings of EMNLP錄用。該工作首先指出現(xiàn)有的有監(jiān)督微調(diào)方法容易收到人類標注偏好數(shù)據(jù)集中噪聲的影響,,然后提出了僅僅使用人類標注的負樣本實現(xiàn)對齊的任務,。以此為目標設計了分布級別優(yōu)化的D2O損失函數(shù),并從理論證明該損失函數(shù)是實例級別優(yōu)化DPO的上界,。在多個開源模型上大量的實驗表明,,D2O在生成質(zhì)量、減少有害性和信息豐富性方面與最新強基線相當或更優(yōu),,并且具有更好的訓練穩(wěn)定性和更快的收斂速度,。

期刊簡介

EMNLP 2024(The 2024 Conference on Empirical Methods in Natural Language Processing)是全球自然語言處理領域的頂級學術會議之一,該會議由計算語言學協(xié)會(Association for Computational Linguistics,,ACL)主辦,,主要集中于自然語言處理(NLP)的實證研究和方法,享有很高的學術影響力,。該會議計劃于2024年11月12日至11月16日在美國佛羅里達州邁阿密召開,。

論文簡介

Negating Negatives: 通過分布級優(yōu)化利用人類標注負樣本實現(xiàn)大語言模型對齊

論文鏈接:

https://arxiv.org/pdf/2403.03419

問題引入

大型語言模型(LLMs)在展示出強大的能力的同時,也帶來了潛在的社會風險,。為了確保LLMs的安全性,,研究者們引入了對齊技術,以使其符合人類價值觀,,代其中代表的技術為基于人類反饋的強化學習(Reinforcement Learning from Human Feedback,RLHF)以及直接偏好優(yōu)化(Direct Preference Optimization,DPO),。其中強化學習利用偏好模型建模人類偏好,,通過強化學習來對齊大語言模型。DPO算法利用Bradley-Terry模型建模人類偏好,,在不用外部顯示偏好模型的情況下,,利用語言模型隱式建模偏好。

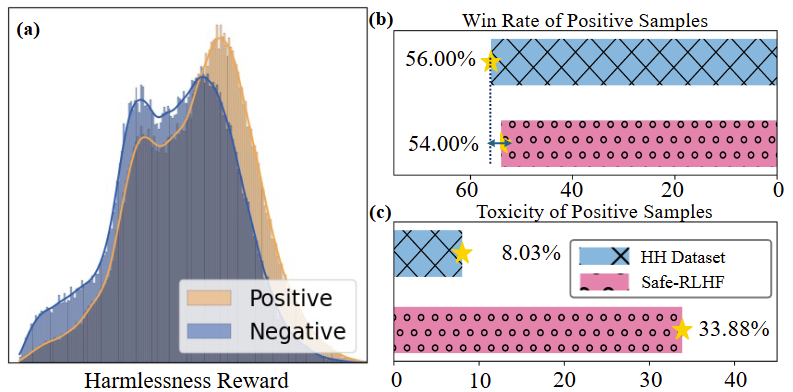

圖 1 (a) HH數(shù)據(jù)集中正樣本和負樣本之間的差異很小,。(b)利用GPT-4進行判斷,,正例的勝率較低。(c)數(shù)據(jù)集正例中存在一定比例的毒性樣本

然而,,現(xiàn)有的方法常常依賴于高質(zhì)量的正負樣本對,。而這些樣本通常是難以獲得的,一方面,,人工標注成本較高難以進行大規(guī)模標注,;另一方面,圖1中展示了我們對當前主流數(shù)據(jù)集進行的質(zhì)量分析,,結果顯示人工標注的一致性較低,,訓練樣本通常含有噪聲。因此在本工作中,,我們提出了一個新的對齊任務,,即:僅僅通過人類標注的負樣本,能否高效地實現(xiàn)對齊,,在盡量減少模型有用性損失的情況下,,盡可能降低模型的有害性。

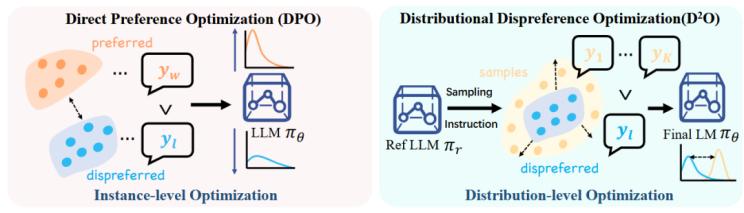

圖2 DPO和D2O對齊流程對比

方法

實現(xiàn)上述目的一種方法是直接降低負樣本輸出的概率,,但這樣往往會導致模型的災難性遺忘,。

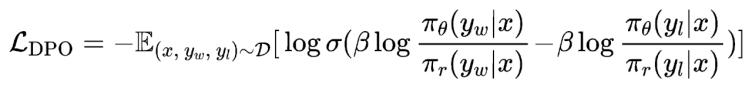

DPO成正負樣本對優(yōu)化的形式很好地避免了這個問題,然而這種從實例級別優(yōu)化方式往往容易收到標注數(shù)據(jù)中噪聲的影響,。因此,,本文首先引入了可控文本生成中的分布控制(Generation with Distributional Control,GDC)問題,,它旨在從分布的角度控制模型的輸出,,如:要求模型輸出內(nèi)容中50%的內(nèi)容涉及女性?;诖?,我們定義了分布級別的偏好建模,并且推導出其建模出來的最優(yōu)獎勵函數(shù)和DPO中的是完全等價的,,進而可以設計出以下的D2O損失函數(shù):

![]()

其中是待對齊的語言模型,,為參考模型,,相較于更加的有害。在具體操作過程中,,我們先用初始模型針對每個負樣本,,生成多個合成的正樣本。然后,,利用上述損失函數(shù)進行優(yōu)化,,其中和以不同頻率進行更新,每次更新以指數(shù)移動平均的形式進行,。此外,,我們在訓練過程中,引入在線采樣的合成正樣本,,進一步提升對齊效果,。

實驗

實驗部分使用了PKU-SafeRLHF數(shù)據(jù)集進行評估,采用Alpaca-7b,、Phi-3-4k-mini-instruct,、Qwen2-1.5B三個不同大小的開源模型進行訓練。對比方法方面,,選取了主流的6種基于有監(jiān)督微調(diào)的方法進行對比,。在評估的指標方面,我們從多角度采用了多種評估的方法,,首先,,我們從無害性、有用性兩個維度選取了4個主流的獎勵模型給模型輸出內(nèi)容進行打分,;使用了GPT-4評判模型生成內(nèi)容相較于原始生成內(nèi)容的勝率,;以及采用MMLU評估對齊稅的大小。

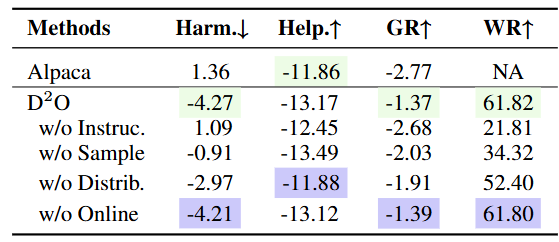

表1 Alpaca-7B實驗結果

表2 消融實驗結果

自動化評估的實驗結果表明,,D2O在減少有害性,、保持有幫助性、提高訓練穩(wěn)定性和加快收斂速度方面均優(yōu)于其他基線方法,。此外,,我們還進行了人工評估,以評估Alpaca,、DPO和D2O生成的響應的無害性和有幫助性,,結果進一步驗證了D2O的有效性。在消融實驗中,,我們對于D2O的多個變體進行了對比,,結果顯示使用self-correction、分布級別優(yōu)化和在線采樣,,有利于性能的提升,。

分析

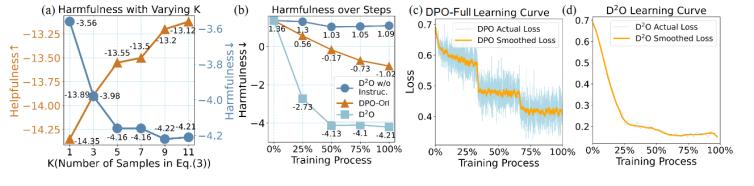

圖3 (a):在采用不同數(shù)量合成正樣本是有害性和有用性的變化,。(b): 隨著訓練進行模型有害性的變化。(c)和(d): 訓練過程中損失函數(shù)的變化,。

我們進一步探究了訓練中采用的正樣本的數(shù)量的影響和以及訓練過程中體現(xiàn)的性質(zhì),。在引入更多的合成正樣本時,,模型的有害性不斷下降,,同時模型的有用性不斷提升,說明引入更多的正樣本能夠減輕對齊稅,。同時,,我們還可以觀察到,在訓練過程中,,D2O的有害性下降將對于DPO更快,,同時損失函數(shù)的下降更加的平滑,這體現(xiàn)了采用分布級別優(yōu)化的優(yōu)點,。

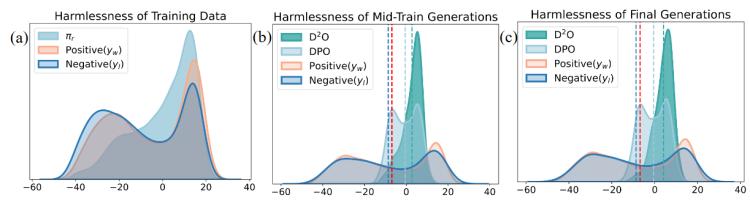

圖4 訓練不同階段模型生成文本獎勵分數(shù)的分布變化

此外,,我們還進一步分析了訓練的不同階段,模型生成內(nèi)容的獎勵分布變化,??梢杂^察到,相比于D2O, DPO對應的獎勵分布具有明顯的雙峰特性,,說明其在優(yōu)化過程中受到了數(shù)據(jù)中噪聲的影響,,而D2O具有明顯的單峰特性,且平均獎勵有著明顯的提升,。

總結

本工作提出了使用人類標注的負面樣本來實現(xiàn)對齊的任務,,并據(jù)此導出了分布級偏好優(yōu)化的損失函數(shù)D2O,有效地減少了有害性,,同時保持了有用性,。實驗結果表明,D2O在減少有害性,、保持有用性,、提高訓練穩(wěn)定性和加快收斂速度方面均優(yōu)于其他基線方法。未來的工作將探索將D2O方法擴展到顯式獎勵建模和RLHF,,并進一步減少大語言模型的對齊稅,。

作者信息

如果您對本文內(nèi)容感興趣的話,可以與作者聯(lián)系:

段士童 復旦大學計算機學院協(xié)同信息與系統(tǒng)實驗室 碩士研究生

研究方向:大語言模型價值觀對齊

聯(lián)系方式:[email protected]

評論 0