ICCV (The International Conference on Computer Vision ) 是計(jì)算機(jī)視覺領(lǐng)域的國際學(xué)術(shù)會(huì)議之一,也是中國計(jì)算機(jī)學(xué)會(huì)評定的A類會(huì)議,。ICCV每兩年舉辦一次,。ICCV 2025將于2025年10月19日-23日在美國夏威夷會(huì)議中心舉行。 PKU-DAIR實(shí)驗(yàn)室《Training-free and Adaptive Sparse Attention for Efficient Long Video Generation》論文被ICCV 2025錄用,。

Training-free and Adaptive Sparse Attention for Efficient Long Video Generation

作者:Yifei Xia, Suhan Ling, Fangcheng Fu, Yujie Wang, Huixia Li, Xuefeng Xiao, Bin CUI

論文鏈接:https://arxiv.org/abs/2502.21079

1. 背景與挑戰(zhàn):

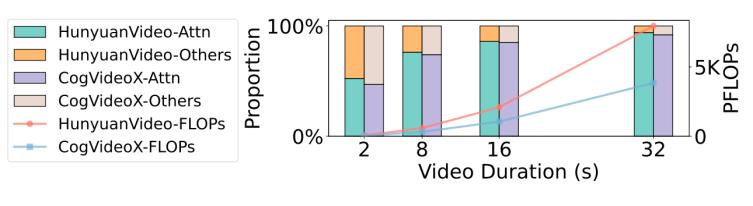

在視頻生成領(lǐng)域,,Diffusion Transformers(DiTs)已經(jīng)成為一種先進(jìn)的生成模型框架,在多模態(tài)生成任務(wù)中取得顯著的效果,。然而,,盡管DiTs在生成高質(zhì)量視頻方面表現(xiàn)出色,但生成長視頻時(shí)仍面臨著巨大的計(jì)算挑戰(zhàn),,特別是在模型的Attention計(jì)算方面,。比如,用HunyuanVideo生成一個(gè)8s 720p的視頻需要大概1h的時(shí)間,,其中Attention計(jì)算占80%,。如圖1所示,Attention的占比會(huì)隨著視頻長度的增加而不斷增加,,成為主要的瓶頸,。

圖1. 不同視頻時(shí)長所需的總FLOPs和Attention占用FLOPs的比例

雖然很多稀疏注意力 (Sparse Attention) 方法已被提出以減輕Attention計(jì)算,但這些方法普遍面臨一個(gè)問題:DiTs中的稀疏范式 (Sparse Pattern) 具有高度的動(dòng)態(tài)性和不規(guī)則性,,現(xiàn)有的靜態(tài)模式和離線搜索方法無法有效適應(yīng)這些變化,,而現(xiàn)有的動(dòng)態(tài)稀疏范式雖然能夠適應(yīng)變化,,但他們大多依賴近似搜索方法,,精度和效率很低,不能實(shí)時(shí)精準(zhǔn)地識(shí)別稀疏范式,,進(jìn)而影響視頻生成的速度和質(zhì)量,。

2. 方法:

上面分析得出,現(xiàn)有的稀疏注意力在DiT長視頻生成的計(jì)算中無法兼顧精度和效率,。為此,,我們在本論文中提出了AdaSpa,首個(gè)「在線精確搜索+動(dòng)態(tài)范式」的稀疏注意力方法,,能在高效加速長視頻生成的同時(shí),,保持極高的精度。

我們首先詳細(xì)分析了DiT視頻生成中稀疏范式的特點(diǎn):1) DiT適用于用塊狀稀疏注意力來建模,,2) DiT稀疏范式隨著去噪步數(shù)不變,,3) DiT稀疏范式隨著Head變化較大,。利用以上特點(diǎn),我們構(gòu)建了AdaSpa,,它是一種結(jié)合「動(dòng)態(tài)塊化范式 + 在線精確搜索 + 頭自適應(yīng)」的新型稀疏注意力機(jī)制,。利用DiT去噪步數(shù)之間的相似性,在某些步驟進(jìn)行精確的在線稀疏范式搜索,,在后續(xù)步驟中復(fù)用這些范式,,以此來減少搜索開銷和增加搜索精度,達(dá)到精度和效率的雙重提升,。

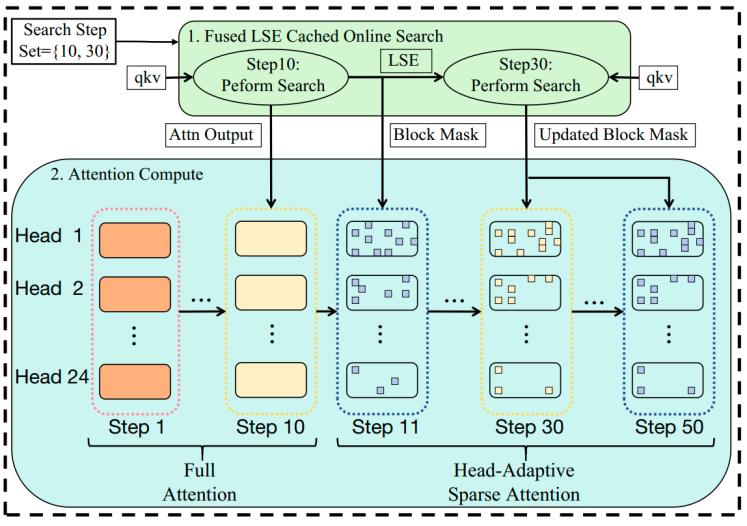

其架構(gòu)圖如圖2所示:

圖2. AdaSpa架構(gòu)圖

具體來說,,AdaSpa在預(yù)定義的搜索步驟 (Search Step Set) 利用自實(shí)現(xiàn)的高效的Fused LSE-Cached Online Search kernel進(jìn)行精確搜索,在其他步驟復(fù)用這些精確范式進(jìn)行稀疏注意力計(jì)算,。 Fused LSE-Cached Online Search kernel將搜索與FlashAttention2耦合,,在搜索步同時(shí)計(jì)算注意力輸出并緩存 LSE,后續(xù)搜索復(fù)用緩存,,進(jìn)一步減少搜索時(shí)間,。其次,根據(jù)不同Head的稀疏度不同,,我們引入 Head-Adaptive Block Sparse Attention,,根據(jù)各Head召回率動(dòng)態(tài)調(diào)整稀疏度以以提高精度并保證kernel的負(fù)載均衡。

3. 實(shí)驗(yàn):

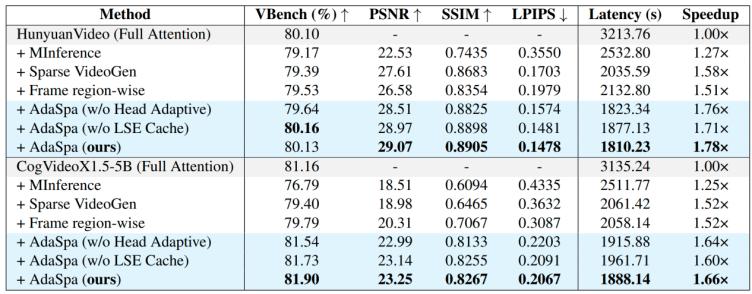

表1. AdaSpa和其他方法的質(zhì)量和延遲的定量評估結(jié)果

為了驗(yàn)證我們方法的有效性,,我們與LLM中最先進(jìn)的的稀疏注意力方法MInference和DiT中最先進(jìn)的的稀疏注意力方法Sparse VideoGen做了對比,,實(shí)驗(yàn)表明我們的方法在速度和效率上均超過了之前的方法。

在本論文中,,我們對DiTs生成視頻注意力機(jī)制中的稀疏特性進(jìn)行全面分析,。基于這些觀察和分析,,我們提出了一種全新的稀疏注意力AdaSpa方法,,該方法具備動(dòng)態(tài)模式與在線精確搜索的能力,能夠加速長視頻的生成,。實(shí)驗(yàn)結(jié)果表明,,AdaSpa在保持生成視頻高質(zhì)量的同時(shí),實(shí)現(xiàn)1.78倍的效率提升,。

實(shí)驗(yàn)室簡介

北京大學(xué)數(shù)據(jù)與智能實(shí)驗(yàn)室(Data And Intelligence Research Lab at Peking Univeristy,,PKU-DAIR實(shí)驗(yàn)室)由北京大學(xué)計(jì)算機(jī)學(xué)院崔斌教授領(lǐng)導(dǎo),長期從事數(shù)據(jù)庫系統(tǒng),、大數(shù)據(jù)管理與分析,、人工智能等領(lǐng)域的前沿研究,在理論和技術(shù)創(chuàng)新以及系統(tǒng)研發(fā)上取得多項(xiàng)成果,,已在國際頂級學(xué)術(shù)會(huì)議和期刊發(fā)表學(xué)術(shù)論文200余篇,,發(fā)布多個(gè)開源項(xiàng)目,。課題組同學(xué)曾數(shù)十次獲得包括CCF優(yōu)博、ACM中國優(yōu)博,、北大優(yōu)博,、微軟學(xué)者、蘋果獎(jiǎng)學(xué)金,、谷歌獎(jiǎng)學(xué)金等榮譽(yù),。PKU-DAIR實(shí)驗(yàn)室持續(xù)與工業(yè)界展開卓有成效的合作,與騰訊,、阿里巴巴,、蘋果、微軟,、百度,、快手、中興通訊等多家知名企業(yè)開展項(xiàng)目合作和前沿探索,,解決實(shí)際問題,,進(jìn)行科研成果的轉(zhuǎn)化落地。

評論 0