該論文發(fā)表于IEEE Journal of Biomedical and Health Informatics (中科院二區(qū),,IF=6.7),,題目為《Cross-Modal Guiding Neural Network for Multimodal Emotion Recognition From EEG and Eye Movement Signals》,。

青島大學(xué)未來研究院和自動化學(xué)院的付寶樂為此論文的第一作者,,青島大學(xué)未來研究院和自動化學(xué)院的劉銀華為此論文的通訊作者,。

論文鏈接:https://ieeexplore.ieee.org/document/10570465

論文概要

情感在人際交往中扮演重要角色,,是傳達(dá)個(gè)體內(nèi)心體驗(yàn)和意圖的媒介,。情感可通過面部表情,、語言語調(diào)和身體動作等方式影響人類的認(rèn)知過程,,包括感知,、思維、決策和記憶等。近年來,,情感識別成為跨神經(jīng)科學(xué)與機(jī)器學(xué)習(xí)等領(lǐng)域的研究熱點(diǎn),。EEG信號作為一種客觀指標(biāo),不易受到人為干擾,,能夠精確反映個(gè)體情緒狀態(tài)的變化,,因此在情感識別領(lǐng)域得到了廣泛應(yīng)用。然而,,人類情感體驗(yàn)表現(xiàn)多樣,,使用單一模態(tài)信號難以捕捉情感的復(fù)雜性。因此,,研究者開始探索通過多模態(tài)信號完成情感識別任務(wù),,例如結(jié)合圖像、音頻以及其他生理信號等進(jìn)行綜合分析,。已有研究表明,,EEG信號和眼動(Eye Tracking,ET)信號具有互補(bǔ)特性,,能夠顯著提升情感識別的準(zhǔn)確率,。傳統(tǒng)的多模態(tài)情感識別方法通常為不同模特單獨(dú)構(gòu)建模型,這種做法忽略了模態(tài)間的內(nèi)在聯(lián)系,,從而可能降低情感識別的準(zhǔn)確性,。為了解決這一問題,本文組合EEG信號和ET信號兩種模態(tài)用于情感識別任務(wù),,并提出了一種跨模態(tài)特征引導(dǎo)神經(jīng)網(wǎng)絡(luò)模型CMGNN,。鑒于EEG信號在情感識別任務(wù)中的高效性和抗干擾能力,該模型利用EEG信號引導(dǎo)ET信號的特征提取,。這一方法不僅有效降低了ET信號受主觀因素影響的風(fēng)險(xiǎn),,還進(jìn)一步挖掘了ET信號中與情感相關(guān)的深層特征。CMGNN模型包含三個(gè)關(guān)鍵部分:雙分支特征提取模塊,、特征引導(dǎo)模塊和特征重加權(quán)模塊,。其中,雙分支特征提取模塊用于提取EEG信號和ET信號的特征,,在壓縮空間和通道維度的同時(shí),,沿時(shí)間維度提取兩種模態(tài)的關(guān)鍵特征;特征引導(dǎo)模塊通過EEG信號特征生成引導(dǎo)因子,,以引導(dǎo)ET信號的特征提取過程,;特征重加權(quán)模塊分析不同通道特征之間的影響和關(guān)聯(lián),對所提取的ET特征進(jìn)行重加權(quán),,從而提升判別能力,。這些模塊的組合,,模型能夠精準(zhǔn)捕捉情緒變化,有效降低ET信號受主觀因素影響的程度,。實(shí)驗(yàn)結(jié)果表明,CMGNN模型在情感SEED-IV數(shù)據(jù)集上的表現(xiàn)優(yōu)于傳統(tǒng)方法,,在自采集的情感數(shù)據(jù)集上的表現(xiàn)證明了模型的強(qiáng)泛化能力,。

研究背景

在情感計(jì)算領(lǐng)域,利用多模態(tài)進(jìn)行情感識別已成為一種趨勢,,尤其是結(jié)合EEG信號和ET信號的情感識別方法受到廣泛關(guān)注,。EEG信號雖然采集過程較為復(fù)雜,但其不易受個(gè)體影響,,能夠精準(zhǔn)反映人類情緒變化,。相比之下,ET信號采集更為便捷,,但容易受到環(huán)境和個(gè)體生理因素的干擾,。為了充分發(fā)揮兩種模態(tài)的優(yōu)勢,本文提出了一種跨模態(tài)特征引導(dǎo)神經(jīng)網(wǎng)絡(luò)(Cross-Modal Guiding Neural Network, CMGNN),。該網(wǎng)絡(luò)旨在通過利用EEG信號在情感識別任務(wù)中的高效性,,指導(dǎo)ET信號的特征提取,減少ET信號中的主觀因素,,同時(shí)提升對ET信號中情感相關(guān)特征的深度挖掘能力,。

數(shù)據(jù)采集

實(shí)驗(yàn)共有10名參與者(5名男性和5名女性),均為右利手,,平均年齡為20±2歲,。參與者具有正常或矯正正常的視力,。

實(shí)驗(yàn)使用40個(gè)約2分鐘的視頻片段,,用于探究人們對不同情感類別的反應(yīng)。通過15名參與者的投票分類,,將視頻分為四種情感類別:傷心(sad),、開心(happy)、害怕(fear)和中性(neural),。為保證實(shí)驗(yàn)的公平性和隨機(jī)性,,從每種情感類別中隨機(jī)選取2個(gè)視頻片段。參與者在觀看每段視頻后,,需評估其中包含的四種情感類別的比例,。

在數(shù)據(jù)采集方面,EEG信號通過64通道的 waveguard 電極帽和 eego 放大器(ANT Neuro)記錄,,電極位置基于國際10-20系統(tǒng),,采樣率為1000 Hz,;ET信號通過 Tobii Pro Glasses 2 眼動儀采集,采樣率為100 Hz,。使WrSysLab平臺內(nèi)置的視覺刺激控制模塊控制視覺刺激的呈現(xiàn)與信號的同步,。

方法

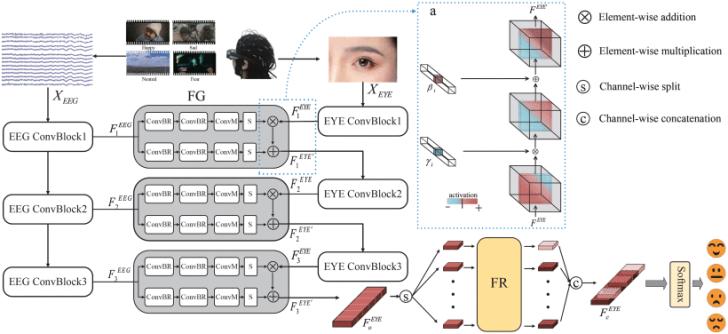

如圖1所示,CMGNN模型包含三個(gè)模塊:雙分支特征提取模塊,、特征引導(dǎo)(FG)模塊和特征重加權(quán)(FR)模塊,。接下來將介紹其各個(gè)組件。

圖1 CMGNN模型的框架

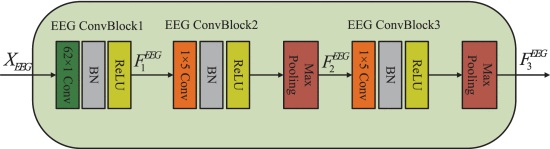

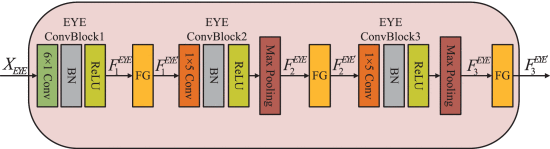

1. 雙分支特征提取模塊

假設(shè)EEG信號和ET信號的情感信息主要沿時(shí)間維度分布,,由于EEG信號的通道數(shù)量顯著多于ET信號,,本研究將重點(diǎn)放在ET特征上,尤其是時(shí)間特征的提取,。在此基礎(chǔ)上,,進(jìn)一步假設(shè),通過壓縮其他維度的信息,,可以有效引導(dǎo)模型關(guān)注時(shí)間特征,,同時(shí)降低計(jì)算復(fù)雜度。為此,,本文提出了一種對稱結(jié)構(gòu)的雙分支特征提取模塊,,每個(gè)分支由三個(gè)卷積特征提取模塊組成。第一個(gè)卷積塊(Convblock1)旨在壓縮空間特征并提取全局空間信息,,而后兩個(gè)卷積塊(ConvBlock2和ConvBlock3)則專注于時(shí)間特征的深度挖掘,。通過這種設(shè)計(jì),該模塊不僅能夠精準(zhǔn)提取關(guān)鍵特征,,還能有效平衡計(jì)算效率與網(wǎng)絡(luò)性能,。

如圖2、3所示,,每一個(gè)卷積塊由1個(gè)卷積層(Conv Layer),、1個(gè)批歸一化層(Batch Normalization)和1個(gè)Rulu激活層(Activation Layer)組成。后兩個(gè)卷積塊后有1個(gè)最大池化層(Max-pooling Layer),。

圖2 EEG特征提取分支

圖3 EYE特征提取分支

2. 特征引導(dǎo)模塊

在情感識別任務(wù)中,,EEG模態(tài)的檢測性能優(yōu)于ET模態(tài)。因此,,提出一種假設(shè):通過EEG特征的引導(dǎo),,可以增強(qiáng)ET特征的表達(dá)。FG模塊的核心目標(biāo)是以EEG特征為引導(dǎo),,提取出與情感更相關(guān)的ET特征,。

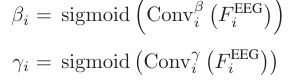

如圖1的灰色區(qū)域所示,F(xiàn)G模塊以EEG ConvBlock的輸出作為輸入,,生成縮放因子和平移因子,,對EYE ConvBlock的輸出進(jìn)行調(diào)制,。每個(gè)FG模塊內(nèi)包含兩個(gè)結(jié)構(gòu)相同的子模塊,用于生成指導(dǎo)因子,。第i個(gè)FG模塊生成的指導(dǎo)因子β和γ的計(jì)算公式如下:

其中,,表示FG模塊內(nèi)的下分支,表示FG模塊內(nèi)的上分支,。Sigmoid函數(shù)作為壓縮函數(shù),,用于生成兩個(gè)指導(dǎo)因子。每個(gè)分支結(jié)構(gòu)依次包括1個(gè)卷積層,、1個(gè)批歸一化層和1個(gè)ReLU激活層,;1個(gè)卷積層,、1個(gè)批歸一化層和1個(gè)ReLU激活層,;1個(gè)卷積層,1個(gè)最大池化層和1個(gè)Sigmoid激活層,。

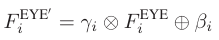

EEG ConvBlcok生成的特征輸入進(jìn)FG模塊后,,所得到的引導(dǎo)因子用于調(diào)節(jié)EYE ConvBlcok輸出的特征,具體公式表達(dá)如下:

其中,,表示調(diào)制的結(jié)果,。⊕表示逐元素加法,表示逐元素乘法,。

3. 特征重加權(quán)模塊

不同通道特征在情感分類中的作用不同,,因此,需要進(jìn)一步分析特征的重要性,,以突出關(guān)鍵特征,。本論文基于Transformer的注意力機(jī)制提出了FR模塊,通過特征間的內(nèi)部相關(guān)性動態(tài)分配權(quán)重,,用于篩選與情感高度相關(guān)的模態(tài)特征,。

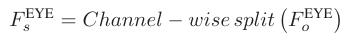

如圖4所示,調(diào)制后的眼動特征按通道維度劃分為n個(gè)部分,,并通過n個(gè)重加權(quán)頭對每部分特征進(jìn)行加權(quán)處理,,以獲得最終輸出。具體的表達(dá)式如下:

其中,,表示ET模態(tài)特征映射,。,表示通過通道劃分得到的第i部分的情感特征,。

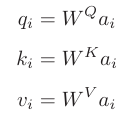

將與3個(gè)矩陣相乘,,產(chǎn)生,,,,,:

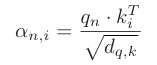

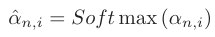

其中,,用于衡量輸入序列中每個(gè)元素與其他元素之間的相關(guān)性。表示輸入序列中每個(gè)元素的特征信息,。表示輸入序列中每個(gè)元素的具體特性,。接著采用向量點(diǎn)積的方法,將分別與進(jìn)行點(diǎn)積,,從而得到注意力α:

其中,,為縮放因子,用于緩解因點(diǎn)積操作大小顯著增大而引發(fā)的梯度消失問題,。所產(chǎn)生的注意力α作為softmax層的輸入,,產(chǎn)生范圍為0-1的注意力權(quán)重:

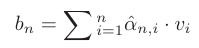

獲得的注意力權(quán)重分別與對應(yīng)位置的v相乘,然后求和:

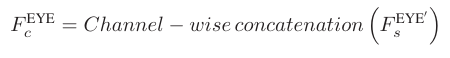

在對每個(gè)通道的特征重新分配權(quán)重后,,將這些特征沿通道方向進(jìn)行拼接:

其中,,。為沿著通道拼接得到的特征,。

最后,,將輸入全連接層,經(jīng)過softmax激活函數(shù)后得到分類結(jié)果,。整個(gè)模型使用交叉熵(cross-entropy)作為損失函數(shù),,定義為:

圖4 FR模塊的框架

實(shí)驗(yàn)和結(jié)果

1. 數(shù)據(jù)預(yù)處理

對于EEG信號,采用0.5Hz-50Hz的巴特沃斯帶通濾波器進(jìn)行濾波,,并通過EEGLAB插值修復(fù)損壞的通道,。此外,利用獨(dú)立成分分析(ICA)分離信號成分,,從而去除肌電和心電等偽影成分,。最后,對預(yù)處理后的EEG信號和ET信號進(jìn)行降采樣,,將時(shí)間維度統(tǒng)一為240個(gè)時(shí)間點(diǎn),。

2. 實(shí)驗(yàn)結(jié)果

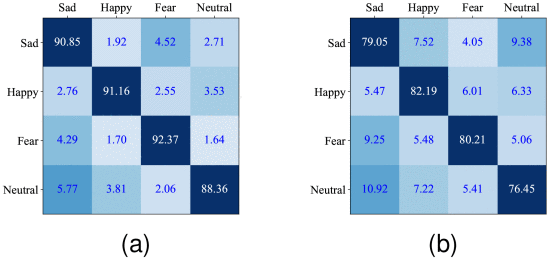

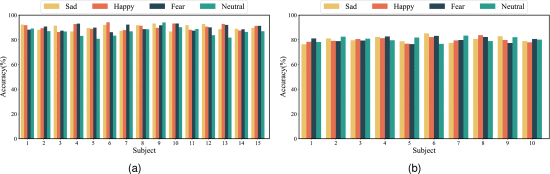

論文在SEED-IV數(shù)據(jù)集和自采數(shù)據(jù)集上進(jìn)行了驗(yàn)證實(shí)驗(yàn),以驗(yàn)證CMGNN在多模態(tài)情感分析任務(wù)上的魯棒性,。如圖5(a)所示,,四種情感的準(zhǔn)確率變化較小,平均準(zhǔn)確率為90.21%,,表明模型具有較好的穩(wěn)定性,。論文還將自采數(shù)據(jù)集作為額外的測試集進(jìn)行驗(yàn)證。如圖5(b)所示,,平均準(zhǔn)確率為79.47%,。盡管準(zhǔn)確率較低,但該實(shí)驗(yàn)的重點(diǎn)在于驗(yàn)證模型在面對新數(shù)據(jù)時(shí)的穩(wěn)定性,,而非追求在特定數(shù)據(jù)集上的絕對準(zhǔn)確性,。

圖5 CMGNN模型的混淆矩陣(左側(cè)為真實(shí)標(biāo)簽,,頂部為預(yù)測標(biāo)簽)。(a)SEED-IV數(shù)據(jù)集上的混淆矩陣,。(b)自采數(shù)據(jù)集上的混淆矩陣,。

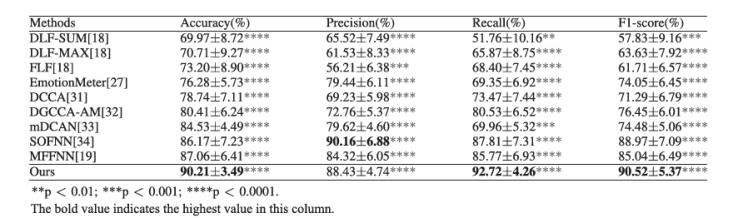

論文比較了模型與其他多模態(tài)情感識別方法的在SEED-IV數(shù)據(jù)集上的表現(xiàn),如表1所示,,模型在所有指標(biāo)上均表現(xiàn)優(yōu)越,,取得了90.21%(p < 0.0001)的準(zhǔn)確率,超越了其他所有模型,。

表1 多模態(tài)方法的比較,。

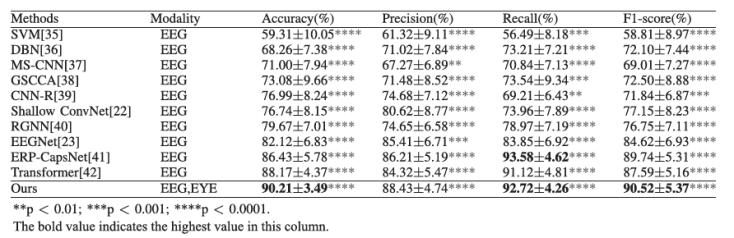

論文還比較了多模態(tài)方法和基于EEG單模態(tài)方法在SEED-IV數(shù)據(jù)集上的表現(xiàn),如表2所示,。結(jié)果表明,,模型在準(zhǔn)確率方面優(yōu)于其他基于EEG的方法。此外,,在召回率和F1-score等其他性能指標(biāo)上,,模型也超越了其他方法,。通過結(jié)合眼動信號(ET信號),,模型在情感識別的表現(xiàn)上超越了單模態(tài)EEG方法,進(jìn)一步突出了融合EEG信號引導(dǎo)ET信號的跨模態(tài)方法的優(yōu)勢,。

表2 基于EEG方法的比較

為了進(jìn)一步評估模型的泛化能力,,論文進(jìn)行了被試獨(dú)立的實(shí)驗(yàn)。圖6(a)展示了SEED-IV數(shù)據(jù)集中15個(gè)受試者的實(shí)驗(yàn)結(jié)果,,圖6(b)展示了自采數(shù)據(jù)集中10個(gè)受試者的實(shí)驗(yàn)結(jié)果,。盡管模型在不同受試者上的表現(xiàn)存在差異,但這些差異并不顯著且較小,,表明模型在面對個(gè)體差異時(shí)具有良好的泛化能力,,能夠保持穩(wěn)定的性能。

圖6 被試獨(dú)立實(shí)驗(yàn),。(a)SEED-IV,。(b)自采數(shù)據(jù)集。

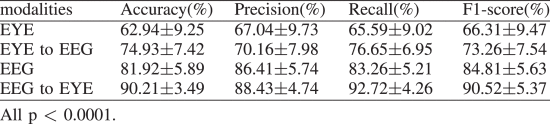

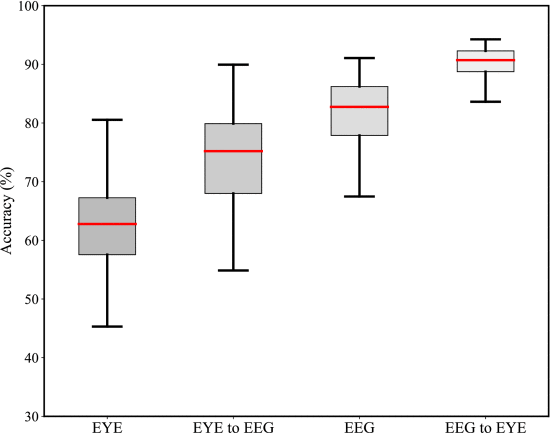

為了驗(yàn)證先前的假設(shè):EEG模態(tài)能夠引導(dǎo)ET模態(tài)的特征提取,,論文進(jìn)行了四個(gè)實(shí)驗(yàn):僅使用眼動信號(EYE特征提取分支與FR),、ET信號引導(dǎo)EEG信號、僅使用EEG信號(EEG特征提取分支與FR)以及EEG信號引導(dǎo)眼動信號,。實(shí)驗(yàn)結(jié)果如表3和圖7所示,。

表3 不同模態(tài)和不同引導(dǎo)方法的結(jié)果。

圖7 不同模態(tài)和不同引導(dǎo)方向的準(zhǔn)確率箱線圖,。

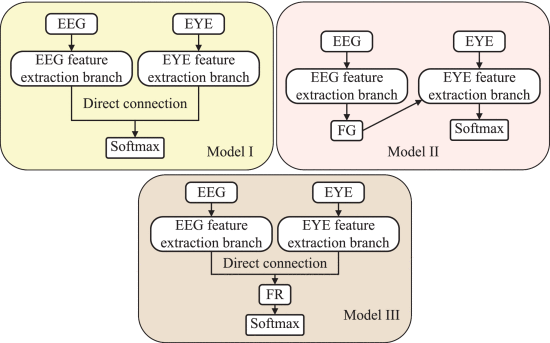

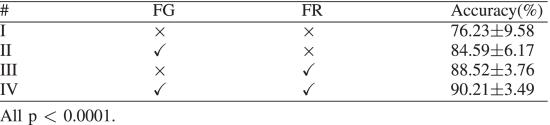

為了驗(yàn)證FG模塊和FR模塊的有效性,,本文進(jìn)行了消融實(shí)驗(yàn),。通過分別去除FG或FR模塊,評估各模塊對模型性能的貢獻(xiàn),。模型Ⅰ僅包含雙分支特征提取模塊,;模型Ⅱ利用EEG特征引導(dǎo)ET信號特征提取,但不包含F(xiàn)R模塊,;模型Ⅲ去除FG模態(tài),,直接將兩種模態(tài)特征拼接,并包含F(xiàn)R模塊,。三種模型的結(jié)構(gòu)如圖8所示,,實(shí)驗(yàn)結(jié)果見表4。

圖8 三種模型的框架

表4 模型消融實(shí)驗(yàn)的結(jié)果,。×表示刪除該模塊,,√表示保留該模塊。

思考與總結(jié)

本論文致力于多模態(tài)情感識別領(lǐng)域,,旨在提高情感識別模型的性能,,并探索EEG和ET信號之間的復(fù)雜關(guān)聯(lián)。為此,,本論文設(shè)計(jì)了CMGNN模型,,通過整合EEG和ET信號實(shí)現(xiàn)多模態(tài)情感識別,該網(wǎng)絡(luò)的核心組件包括雙分支特征提取模塊,、多個(gè)FG模塊和一個(gè)FR模塊,。這些模塊的協(xié)同工作使得模型能夠準(zhǔn)確捕捉情感變化,減輕主觀因素的影響,,并挖掘ET信號中與情感相關(guān)的特征,。在SEED-IV數(shù)據(jù)集和自采數(shù)據(jù)集上進(jìn)行了全面實(shí)驗(yàn)。實(shí)驗(yàn)結(jié)果表明,,模型在情感識別任務(wù)中展現(xiàn)出顯著的性能優(yōu)勢,,達(dá)到了比傳統(tǒng)情感識別方法更高的準(zhǔn)確度。盡管模型在特定的情感識別任務(wù)中表現(xiàn)出色,,但仍然存在一些未解決的問題,,如情感估計(jì)的客觀性和個(gè)體在情感處理上的差異。

撰稿人:黃華星

審稿人:黃海云