第 47 屆 IEEE 醫(yī)學和生物工程學會國際會議(Annual International Conference of the IEEE Engineering in Medicine and Biology Society,,簡稱 EMBC 2025)將于 2025 年 7 月 14 日至 17 日在丹麥哥本哈根舉行。作為生物醫(yī)學工程領域歷史悠久的旗艦會議,,EMBC 同時也是中國人工智能學會(CAAI)推薦的 B 類會議,。在此次會議上,腦機交互與混合智能團隊共有 4 篇研究成果被錄用,,取得了豐碩成果,。

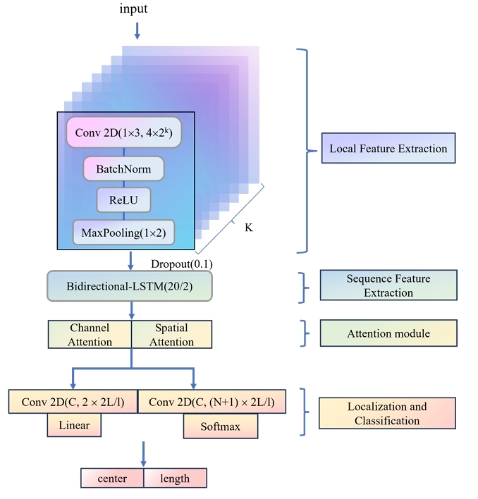

2023級研究生李澳琪在潘家輝老師、曲超老師的指導下,,研究成果《SpindleX: A Multi-Scale Event Detection Window and CBAM Attention-Based Model for Sleep Spindle Detection》被錄用并進行全文發(fā)表,。算法利用卷積神經網絡和雙向長短期記憶網絡提取常見的紡錘波特征,之后使用注意力模塊從信號的通道和空間方面捕捉更多細節(jié),,采用多尺度事件檢測窗口來適應紡錘波不同的持續(xù)時間,,旨在捕捉 EEG 序列中的所有紡錘波。主要貢獻包括:

(1)提出了一種基于單通道腦電信號的紡錘波檢測算法,,該算法在公開數(shù)據集MASS-SS2上表現(xiàn)出色,。具體結構如下:

圖1 SpindleX模型架構圖

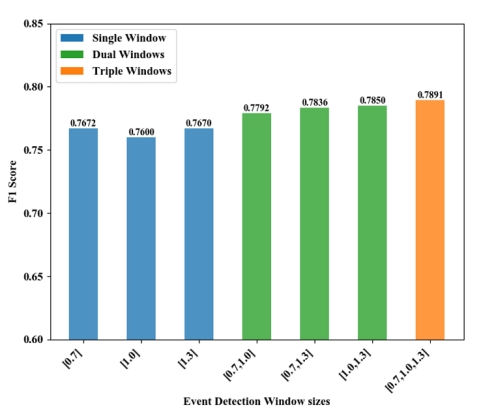

(2)采用多尺度事件檢測窗口來捕捉不同持續(xù)時間的睡眠紡錘波,盡可能最小化真實紡錘波事件與信號段內預測的紡錘波事件之間的偏差,。

圖2 不同大小的事件檢測窗口對檢測結果的影響

(3)將CBAM注意力機制集成到 SpindleX 中,,這增強了對通道和空間信息的提取能力,使模型能夠聚焦于 EEG 信號的顯著特征,。通過學習突出紡錘波最重要的特征,,SpindleX 相比傳統(tǒng)的基于閾值的方法,能更有效地適應不同的信號,。

(4)利用紡錘波突出于背景腦電活動的特點,,使用卷積層進行局部特征提取,使用雙向長短期記憶網絡對時間依賴性進行建模,,使模型能夠更好地學習上下文信息,,在保留空間和時間信息的同時,避免了基于圖像的方法所帶來的存儲和效率成本問題,。

表1 SpindleX(本研究方法)與其他方法的對比分析

2. 基于腦電微狀態(tài)分析對意識障礙患者情緒解碼和意識評估

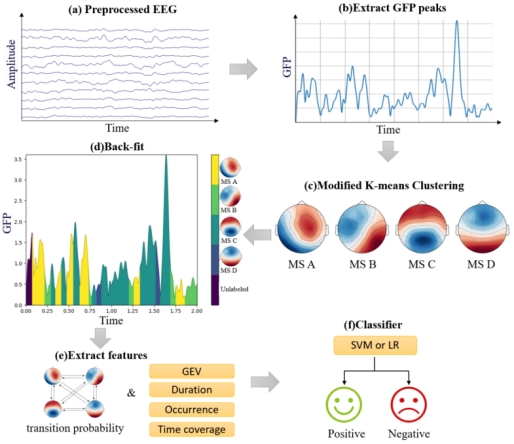

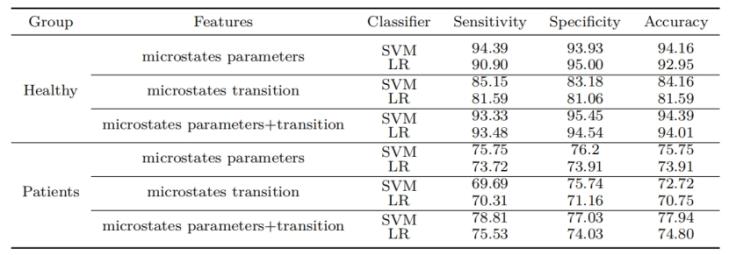

2023級研究生陳志強在黃海云老師的指導下,,研究成果《Emotion Decoding and Consciousness Evaluation in DOC Patients through EEG Microstate analysis》被錄用并進行全文發(fā)表。本研究利用機器學習對意識障礙患者的情緒狀態(tài)進行分類,,系統(tǒng)探討了腦電微狀態(tài)的參數(shù)和轉移概率與健康被試的差異,。實驗結果證明,腦電微狀態(tài)的參數(shù)和轉移概率在一定程度上可以作為判斷意識障礙患者情緒狀態(tài)的指標,。本文主要貢獻包括:

(1)本研究使用腦電微狀態(tài)方法用于評估意識障礙患者,,分析在情緒識別中的作用,并進一步探討了其在定量分析中的應用潛力。

圖1 腦電微狀態(tài)分析過程

(2)本研究將頻譜特征與微觀狀態(tài)特征相結合,。在獨立測試集上實現(xiàn)了77.94%的分類準確率,我們的系統(tǒng)對意識障礙患者的情緒進行分類的能力提供了保留情緒意識的電生理證據,,即使在行為輸出有限的患者中也是如此,。

表1 在情緒識別實驗中,健康受試者和意識障礙患者的分類結果(%)

(3)確定微狀態(tài)參數(shù)和轉移概率作為意識障礙評估的新生物標志物,。這在情緒相關的微狀態(tài)轉換和意識障礙嚴重程度之間建立了直接聯(lián)系,,為CRS-R等行為量表提供了神經生理學補充。

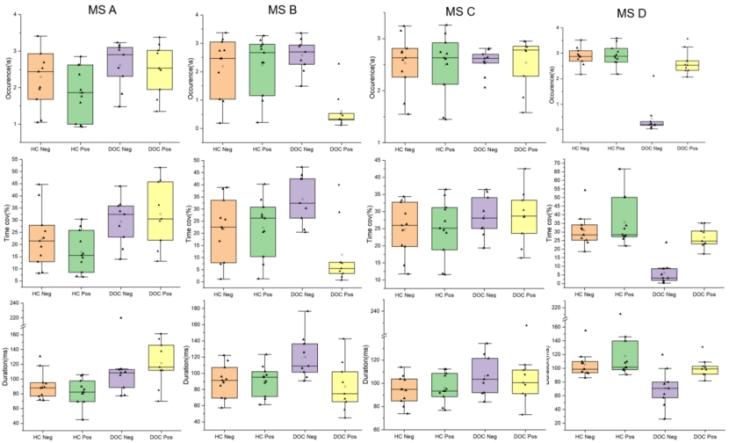

圖2 健康對照組(HC)和意識障礙(DOC)組之間的微狀態(tài)參數(shù)差異,。誤差條:SEM*p<0.05,,**p<0.01

3. DC-FFNet:用于實時異步信號分析的雙通道特征融合網絡

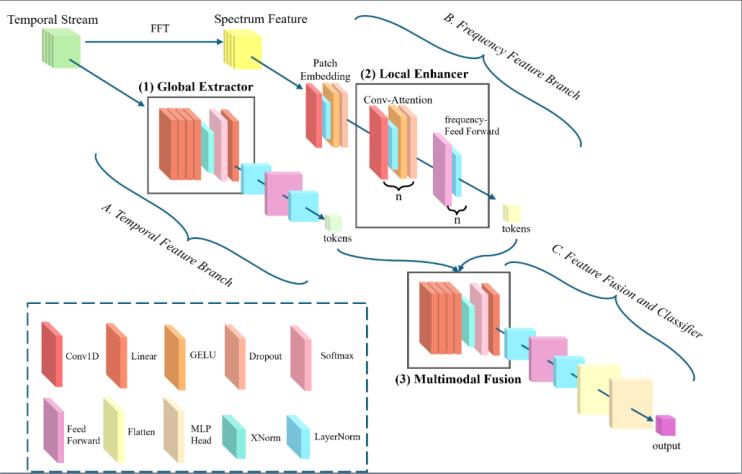

2022級本科生孫瑜妤在潘家輝老師的指導下,研究成果《DC-FFNet: Dual Channel Feature Fusion Network for Real-Time Asynchronous Signal Analysis》被錄用并進行全文發(fā)表,。本文主要研究了在提出的實時控制框架下,,基于雙通道架構使用多頭自注意力機制,實現(xiàn)全局特征捕捉,、局部特征增強和多模態(tài)特征融合,,高效地融合異步信號的時空特征,實現(xiàn)高實時性與SSVEP 信號的分類高精度,。主要貢獻包括:

(1)本研究提出了一種基于雙通道特征融合網絡(DC-FFNet)的SSVEP 的信號分類模型,,該算法在公開數(shù)據集SSVEP SANDIEGO和自采集數(shù)據集上均表現(xiàn)出色。具體結構如下:

圖3 DC-FFNet模型架構圖

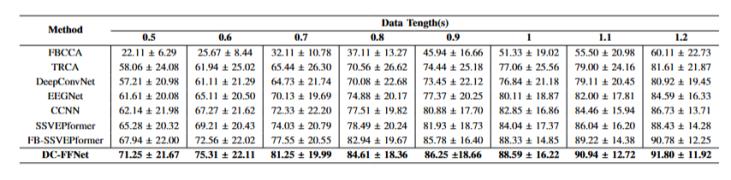

表1 公開數(shù)據集上DC-FFNet性能對比結果

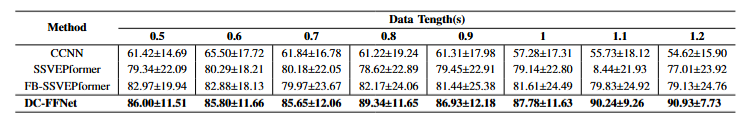

表2 自采數(shù)據集上DC-FFNet性能對比結果

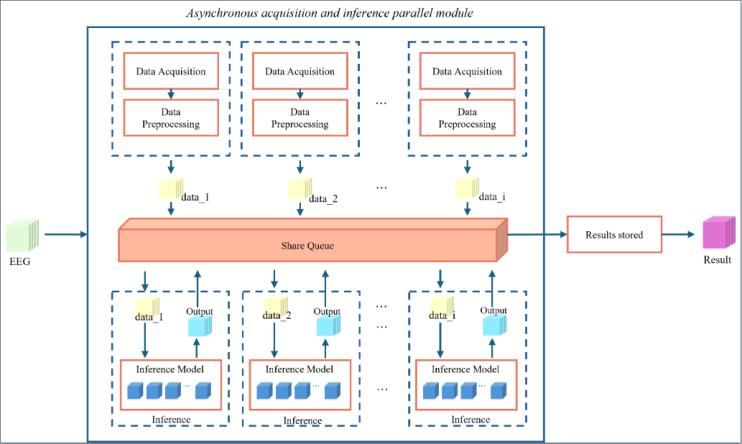

(2)本研究構建了一個基于異步編程的實時控制框架,,引入了并行異步采集和推理的并行機制,,以及靈活的異步任務調度策略,以確保系統(tǒng)的實時性,。實驗表明,,與傳統(tǒng)的同步控制相比,該框架的平均響應時間縮短了 29.6%,,總時延保持在1.5s以下,。

圖4 異步控制框架圖

(3)在并行異步采集的流程中,本研究構建了一個高質量的自采數(shù)據集,,利用基線模型測試了數(shù)據集的合理性和,。同時,在該數(shù)據集上DC-FFNet(本研究方法)的性能始終優(yōu)于基線模型,。

(4)本研究的整體架構支持在線處理,,突破了傳統(tǒng)離線方法的實時性瓶頸,顯著提升了腦-機接口系統(tǒng)的實用性與響應效率,。本框架集成輕量化模型結構與快速響應機制,,實現(xiàn)了低延遲、高精度的實時腦信號解碼,。)

4. 基于自監(jiān)督對比學習方法的自動睡眠分期模型MultiConsSleepNet

2022級研究生余陽祖怡在潘家輝老師的指導下,,研究成果《MultiConsSleepNet: Self-Supervised Contrastive Learning for a Multimodal Consistency-Based Automatic Sleep Staging Model》被EMBC 2025錄用為full paper,。該論文針對自動睡眠分期技術中如何高效提取具有強泛化能力的多模態(tài)特征、如何利用多模態(tài)信號的相似性和差異性進行準確分期,,以及如何充分利用大量未標記數(shù)據來增強模型的實用性,,提出了一種創(chuàng)新的解決方案。該方案的亮點如下:

(1)多模態(tài)特征提取與一致性增強

本文設計了一種新穎的多模態(tài)一致性網絡(MultiConsSleepNet),。該網絡通過整合單模態(tài)特征提取器與多模態(tài)一致性提取器,,能夠精準捕捉腦電圖(EEG)和眼動圖(EOG)信號的局部域特征。這種設計不僅增強了模態(tài)內特征的一致性,,還通過跨模態(tài)對比學習,,進一步提升了模態(tài)間特征的對齊程度。通過對比學習策略,,模型在原始數(shù)據和增強數(shù)據上進行訓練,,并利用殘差通道注意力塊進一步提升特征提取器的泛化和表示能力。這使得模型能夠在復雜多變的睡眠信號中提取出更具代表性和魯棒性的特征,。

(2)模擬臨床噪聲提升魯棒性

在實際臨床環(huán)境中,,睡眠監(jiān)測信號常常受到各種噪聲的干擾,這給自動睡眠分期帶來了巨大挑戰(zhàn),。為了解決這一問題,,本文在研究中引入隨機高斯噪聲來模擬臨床環(huán)境中的噪聲,并通過在噪聲數(shù)據上進行對比學習,,顯著增強了特征提取器的魯棒性和泛化能力,。這種創(chuàng)新方法使得模型能夠在面對實際應用中的復雜噪聲時,依然能夠穩(wěn)定地進行睡眠分期,,極大地提升了模型的實用性和可靠性,。

(3)自監(jiān)督預訓練策略

為了充分利用大量未標記的睡眠數(shù)據,本文提出了一種創(chuàng)新的自監(jiān)督預訓練策略,。該策略利用自監(jiān)督對比學習對單模態(tài)特征提取器和多模態(tài)一致性結構進行預訓練,,使用大量未標記的睡眠數(shù)據來提升模型的初始性能。隨后,,通過微調,,模型能夠快速適應不同的睡眠分期數(shù)據集,展現(xiàn)出卓越的適應性和實用性,。這一策略不僅極大地降低了對大量標記數(shù)據的依賴,,還顯著提升了模型的泛化能力,使其能夠在不同數(shù)據集和應用場景中表現(xiàn)出色,。