2025年IEEE國際聲學(xué),、語音與信號處理會議(IEEE International Conference on Acoustics, Speech, and Signal Processing, ICASSP 2025)將于2025年4月6日至11日在印度海得拉巴隆重舉行,。作為IEEE信號處理學(xué)會的旗艦會議,ICASSP致力于推動聲學(xué),、語音和信號處理領(lǐng)域的前沿研究與創(chuàng)新,,并促進跨學(xué)科合作與交流,。每年,,該會議都會吸引全球頂尖學(xué)者和工程師匯聚一堂,,是信號處理領(lǐng)域極具影響力的學(xué)術(shù)盛會之一,也被中國計算機學(xué)會列為權(quán)威學(xué)術(shù)會議(CCF B類),。在本次會議中,,由潘家輝、梁艷,、王斐等老師指導(dǎo)的團隊成員郝巖,、陳明輝、李卓蓉,、鄭澤昆,,憑借出色的研究成果,成功投稿了4篇論文,,且均以full paper形式被順利錄用,。

論文1:

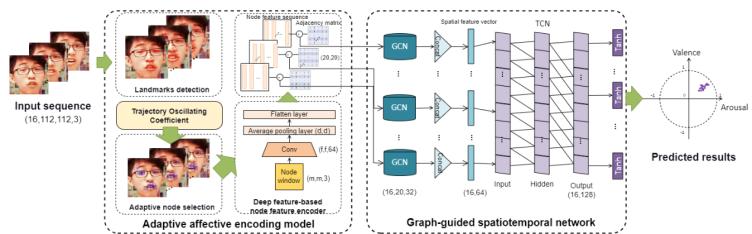

郝巖(2021級研究生)和梁艷老師研究成果《An End-to-End Graph-Guided Spatiotemporal Model for Adaptive Frame-Level Facial Affect Analysis in the Wild》的主要工作:

實驗結(jié)果表明,該方法優(yōu)于最先進的方法,。此外,,所提出的方法在端到端的愉悅度-喚醒度(valence-arousal, VA)估計方面的有效性也得到了可視化,。

圖1 GSTCN模型結(jié)構(gòu)圖

論文2:

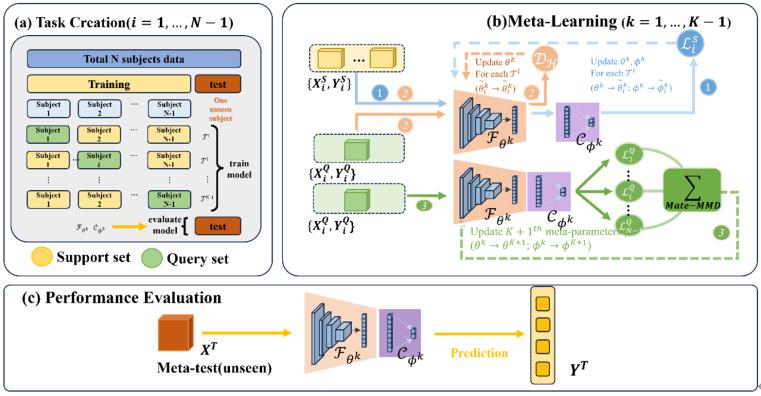

陳明輝(2023級研究生)和潘家輝教授的研究成果《Meta-MMD Fusion: Enhancing Cross-Subject Motor Imagery Classification》主要貢獻(xiàn)如下:

圖2 Meta-MMD結(jié)構(gòu)圖

論文3:

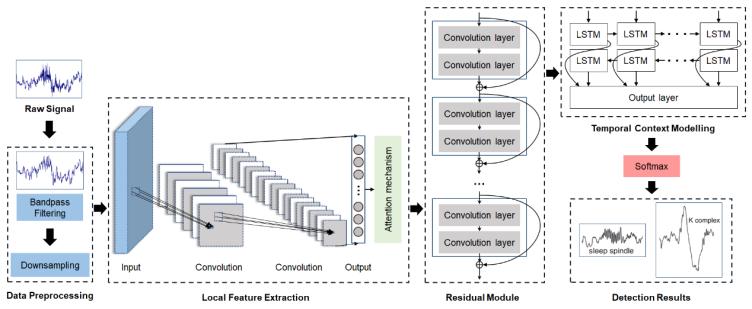

李卓蓉(2022級研究生)和王斐副教授研究成果《DARN: An Attention-Based Neural Network Using Residual Blocks for Sleep Micro-Events Detection》的主要工作:

1. 基于卷積神經(jīng)網(wǎng)絡(luò),結(jié)合注意力機制與雙向長短期記憶單元來提取時間特征,,有效地捕獲了時間序列中的長距離依賴關(guān)系,,提高檢測的性能和模型的魯棒性。

2. 引入殘差模塊,,促進更深層次網(wǎng)絡(luò)的訓(xùn)練,。該方法解決了梯度消失和網(wǎng)絡(luò)退化等常見問題,從而提升檢測精度,,使得模型更加準(zhǔn)確地識別潛在的睡眠特征波,。

3. 研究的方法用于檢測不同的睡眠特征波,包括睡眠紡錘波和K復(fù)合波,,驗證方法的泛化能力以及不同場景和數(shù)據(jù)分布下的穩(wěn)健性,。

圖3 DARN模型結(jié)構(gòu)圖

論文4:

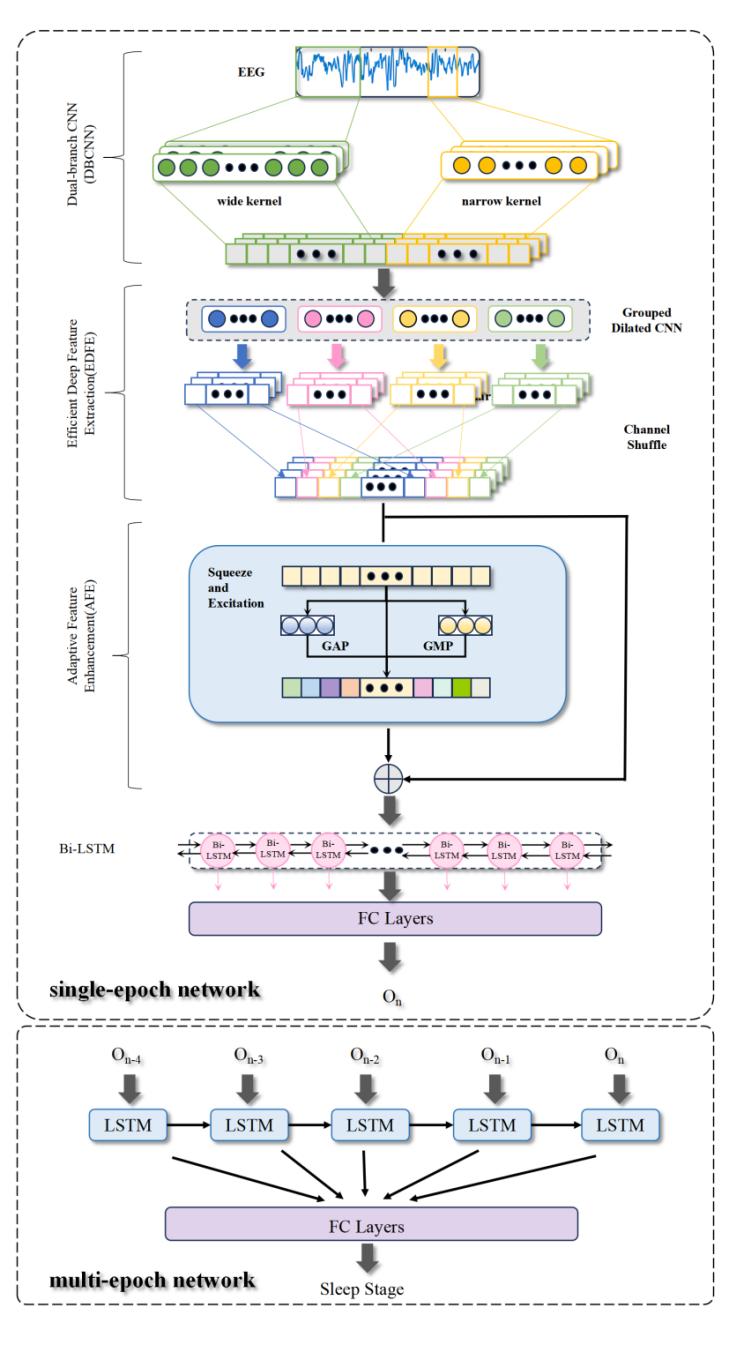

鄭澤昆(2023級研究生)和王斐副教授研究成果《EfficientSleepNet: A Novel Lightweight End-to-End Model for Automated Sleep Staging on Single-Channel EEG》的主要工作:

圖4 EfficientSleepNet模型結(jié)構(gòu)圖