第27屆IEEE國(guó)際多媒體會(huì)議(IEEE International Conference on Multimedia and Expo,,簡(jiǎn)稱(chēng) ICME)將于 2025 年 6 月 30 日至 7 月 4 日在法國(guó)南特(Nantes)隆重舉行。ICME是計(jì)算機(jī)多媒體領(lǐng)域最具權(quán)威性和影響力的兩大國(guó)際旗艦會(huì)議之一,,同時(shí)也是CCF(中國(guó)計(jì)算機(jī)學(xué)會(huì))和CAAI(中國(guó)人工智能學(xué)會(huì))推薦的B類(lèi)會(huì)議,。在此次會(huì)議上,腦機(jī)交互與混合智能團(tuán)隊(duì)有5篇研究成果被錄用,,取得了豐碩成果,。

1. 國(guó)際上首個(gè)開(kāi)源的指形認(rèn)證數(shù)據(jù)集 FinSeg

黃俊端副研究員聯(lián)合華南理工大學(xué)康文雄教授,、貴州民族大學(xué)羅達(dá)燦教授和楊偉力教授,共同發(fā)表了題為《Study of Finger Biometrics on Finger Semantic Segmentation and Finger Shape Authentication》的研究論文,。該研究聚焦于指形身份識(shí)別這一新興領(lǐng)域,,首次專(zhuān)門(mén)深入探討指形在身份識(shí)別中的效果與作用,具有一定的創(chuàng)新性,。

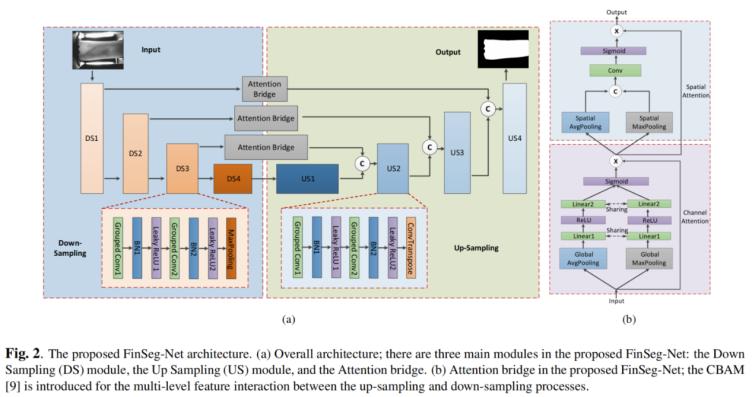

(1)基于全視圖指靜脈數(shù)據(jù)集 MFFV(MFFV 數(shù)據(jù)集),,團(tuán)隊(duì)構(gòu)建了國(guó)際上首個(gè)開(kāi)源的指形認(rèn)證數(shù)據(jù)集 FinSeg(FinSeg 數(shù)據(jù)集),為后續(xù)相關(guān)研究提供了寶貴的數(shù)據(jù)資源,,有力推動(dòng)了手指生物特征識(shí)別技術(shù)的發(fā)展,。此外,團(tuán)隊(duì)設(shè)計(jì)了一個(gè)簡(jiǎn)單,、直接,、輕量化的指形語(yǔ)義分割模型 FinSeg-Net,成功實(shí)現(xiàn)了指形與指靜脈特征的解耦,,精準(zhǔn)提取指形掩碼,為進(jìn)一步的身份識(shí)別研究奠定了基礎(chǔ),。

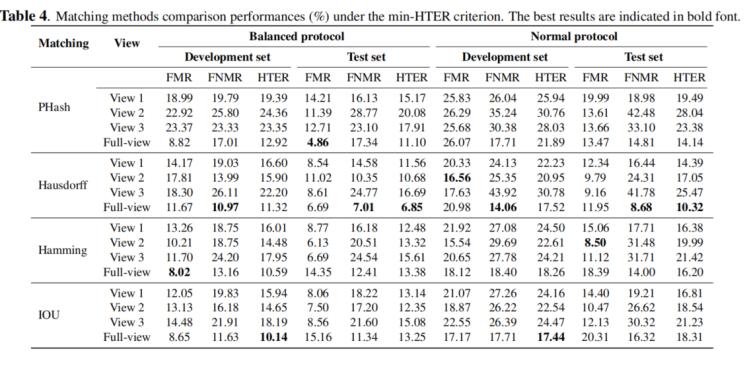

(2)為確保研究成果的可復(fù)現(xiàn)性和可參考性,,團(tuán)隊(duì)還提供了一套全面、系統(tǒng)性,、規(guī)范化的指形認(rèn)證基準(zhǔn)實(shí)驗(yàn),。這一基準(zhǔn)實(shí)驗(yàn)為后續(xù)相關(guān)研究提供了公平性、一致性的實(shí)驗(yàn)參考,,有助于引導(dǎo)該領(lǐng)域研究朝著更加科學(xué),、規(guī)范的方向發(fā)展,促進(jìn)指形生物特征識(shí)別技術(shù)的不斷完善和應(yīng)用拓展,。

2. 運(yùn)動(dòng)想象腦機(jī)接口跨被試分類(lèi)模型

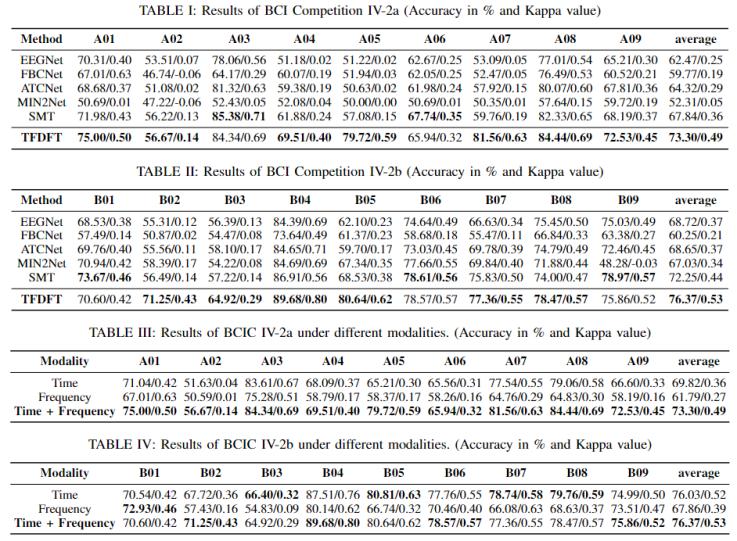

2023 級(jí)研究生夏梓健發(fā)表了《Time-Frequency Domain Fusion Transformer for Cross-Subject Motor Imagery Classification》研究工作,,在腦機(jī)接口領(lǐng)域的運(yùn)動(dòng)想象分類(lèi)研究中取得了重要突破,指導(dǎo)老師為潘家輝教授,。主要貢獻(xiàn)包括:

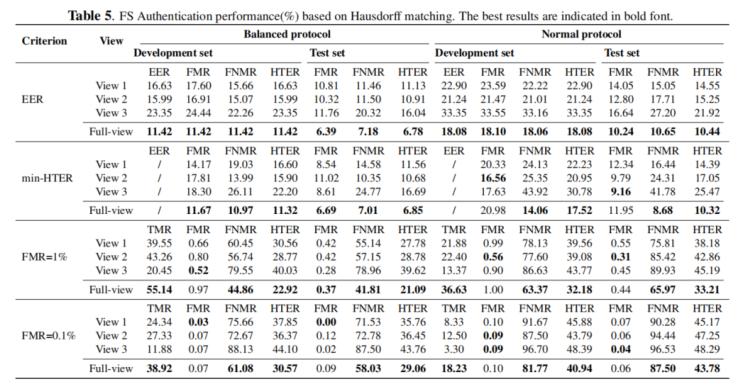

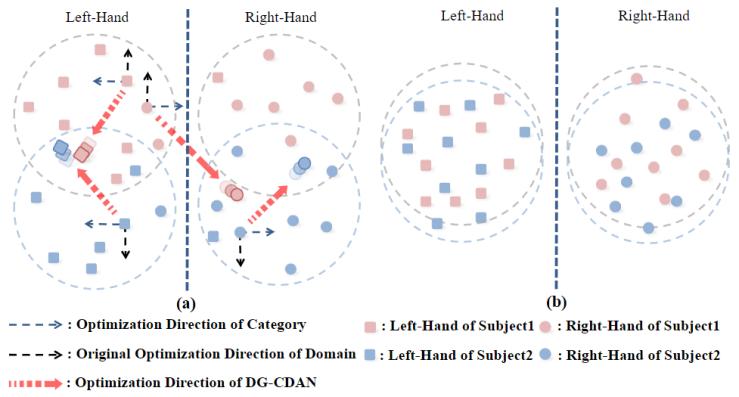

(1)提出了一種結(jié)合時(shí)間態(tài)和頻率態(tài)數(shù)據(jù)的運(yùn)動(dòng)想象分類(lèi)模型——Time-Frequency Domain Fusion Transformer,。該模型創(chuàng)新性地使用三個(gè)電極通道實(shí)現(xiàn)域泛化的運(yùn)動(dòng)想象分類(lèi)目標(biāo),有效克服了傳統(tǒng)方法在跨被試運(yùn)動(dòng)想象分類(lèi)中面臨的個(gè)體差異大,、泛化能力差等問(wèn)題,,為腦機(jī)接口技術(shù)在實(shí)際應(yīng)用中的推廣提供了有力支持。

(2)在經(jīng)典域適應(yīng)方法 CDAN 的基礎(chǔ)上,,團(tuán)隊(duì)進(jìn)一步拓展提出了 DG-CDAN,,并將其成功應(yīng)用于多領(lǐng)域域泛化的應(yīng)用中。通過(guò)在分類(lèi)訓(xùn)練中學(xué)習(xí)泛化特征,,DG-CDAN 有效提升了模型在不同被試之間的泛化能力,,進(jìn)一步提高了運(yùn)動(dòng)想象分類(lèi)的準(zhǔn)確性和穩(wěn)定性,。

(3)在兩個(gè)數(shù)據(jù)集上的實(shí)驗(yàn)結(jié)果均表明,該方法取得了最優(yōu)的實(shí)驗(yàn)結(jié)果,,充分證明了其在少通道跨被試的運(yùn)動(dòng)想象分類(lèi)中的有效性,。這一成果為腦機(jī)接口技術(shù)在康復(fù)醫(yī)療、人機(jī)交互等領(lǐng)域的應(yīng)用提供了新的技術(shù)手段,,有望推動(dòng)腦機(jī)接口技術(shù)的進(jìn)一步發(fā)展和普及,。

3. 基于VAE的少樣本學(xué)習(xí)創(chuàng)新性方法

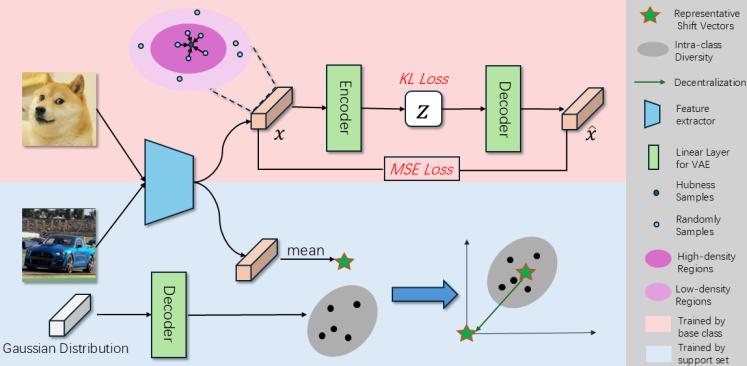

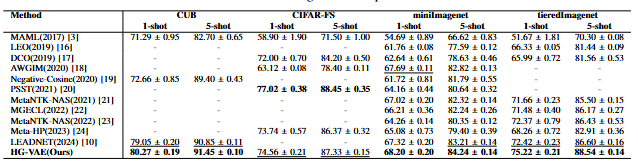

2023 級(jí)研究生陳泉霖和2022級(jí)研究生葉春錦發(fā)表研究成果《A Novel Perspective on Leveraging Hubness in VAE for Eliminating Representative Shift Vectors in Few-Shot Learning》在少樣本學(xué)習(xí)領(lǐng)域提出了創(chuàng)新性方法,指導(dǎo)老師為李景聰副教授,。主要貢獻(xiàn)包括:

(1)該研究突破傳統(tǒng)思維,,使用可學(xué)習(xí)的生成式變分自編碼器(VAE)模型代替了以往高斯分布的強(qiáng)假設(shè),巧妙地將分布劃分為代表性偏移向量和類(lèi)內(nèi)多樣性,。這一創(chuàng)新設(shè)計(jì)使網(wǎng)絡(luò)能夠有效學(xué)習(xí)新類(lèi)別的類(lèi)內(nèi)多樣性,,并間接學(xué)習(xí)其特征分布,為少樣本學(xué)習(xí)中的類(lèi)別學(xué)習(xí)提供了新的思路,。

(2)以往研究多將 Hubness 性質(zhì)視為負(fù)面屬性加以避免,,而本研究團(tuán)隊(duì)另辟蹊徑,首次在少樣本學(xué)習(xí)領(lǐng)域?qū)?Hubness 屬性視為積極屬性并加以深入研究,。通過(guò)利用 Hubness 特性指導(dǎo) VAE 生成高質(zhì)量樣本,,為少樣本學(xué)習(xí)中的樣本生成問(wèn)題提供了有效解決方案,進(jìn)一步提升了模型對(duì)新類(lèi)別的學(xué)習(xí)能力和泛化性能,。

(3)在四個(gè)數(shù)據(jù)集上進(jìn)行的廣泛實(shí)驗(yàn)充分驗(yàn)證了所提方法的有效性,,取得了最優(yōu)或次優(yōu)的性能表現(xiàn)。這一成果為少樣本學(xué)習(xí)領(lǐng)域的研究提供了新的視角和方法,,有望推動(dòng)該領(lǐng)域在更多實(shí)際應(yīng)用場(chǎng)景中的落地與發(fā)展,,解決少樣本場(chǎng)景下的分類(lèi)識(shí)別難題。

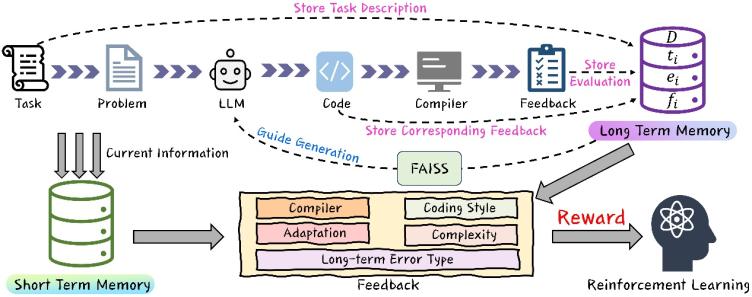

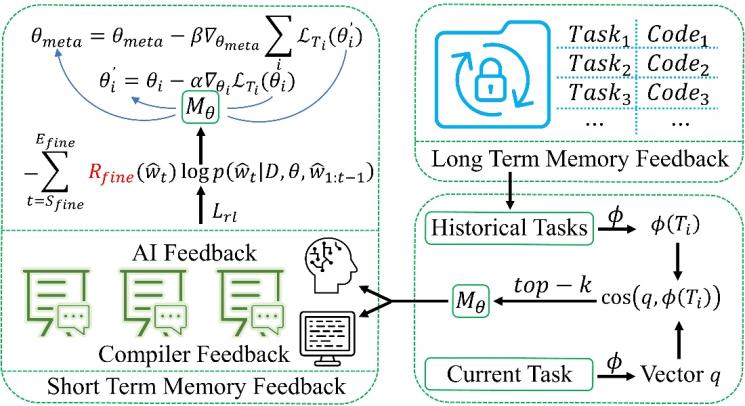

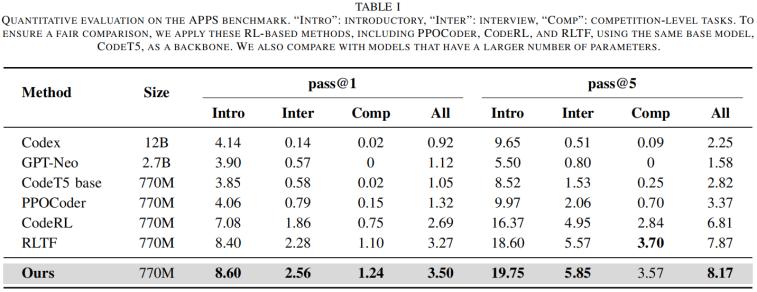

4. 代碼生成領(lǐng)域提出“雙記憶”策略

2023 級(jí)研究生李澤遠(yuǎn)在何樂(lè)為副研究員的指導(dǎo)下發(fā)表研究成果《FALCON: Feedback-driven Adaptive Long/short-term memory reinforced Coding Optimization》,。針對(duì)代碼生成大模型在現(xiàn)有基于編譯反饋的強(qiáng)化學(xué)習(xí)框架中的不足,提出了創(chuàng)新性的“雙記憶”策略,。

(1)該策略從全局和局部?jī)蓚€(gè)層面入手,,從全局層面利用長(zhǎng)時(shí)記憶記錄高質(zhì)量樣本、錯(cuò)誤類(lèi)型與修復(fù)經(jīng)驗(yàn),,從局部層面利用短時(shí)記憶接收實(shí)時(shí)編譯和單元測(cè)試反饋,。這種“雙記憶”機(jī)制使模型能夠迅速發(fā)現(xiàn)并糾正短期錯(cuò)誤,同時(shí)借鑒歷史最優(yōu)代碼經(jīng)驗(yàn),,顯著降低了重復(fù)錯(cuò)誤率并提升了收斂速度,,有效提高了代碼生成的質(zhì)量和效率。

(2)將多維度非差分特征納入反饋回路,通過(guò)整合編譯反饋,、AI 風(fēng)格評(píng)分,、代碼復(fù)雜度評(píng)價(jià)等多維度指標(biāo),不僅在最終功能正確性上有明顯提升,,還兼顧了代碼可讀性和最佳實(shí)踐等實(shí)際編程需求,,使生成的代碼更符合實(shí)際開(kāi)發(fā)中的規(guī)范和要求。

(3)在 APPS,、HumanEval,、MBPP、CODAL-Bench 等多個(gè)權(quán)威測(cè)試集上的驗(yàn)證結(jié)果表明,,F(xiàn)ALCON 展現(xiàn)出優(yōu)異的代碼準(zhǔn)確度,,充分證明了該方法的有效性。這一成果為代碼生成領(lǐng)域的發(fā)展提供了新的技術(shù)思路和方法,,有望推動(dòng)代碼生成技術(shù)在軟件開(kāi)發(fā)中的廣泛應(yīng)用,,提高開(kāi)發(fā)效率和代碼質(zhì)量。

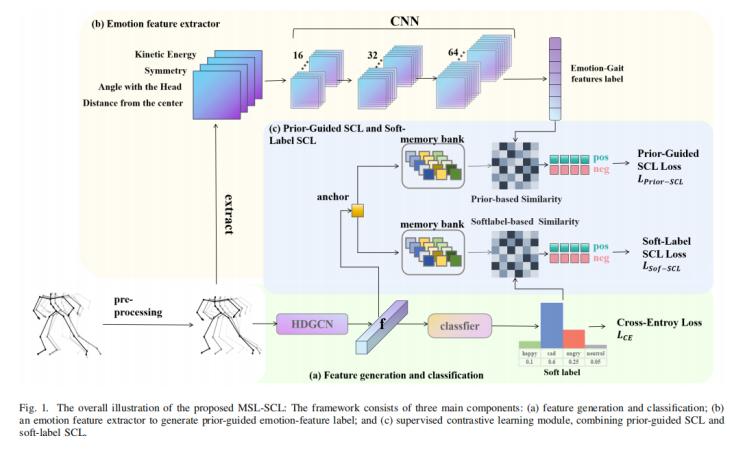

5. 步態(tài)情緒識(shí)別高效學(xué)習(xí)框架

2023 級(jí)研究生續(xù)夢(mèng)昕在周成菊老師指導(dǎo)下發(fā)表研究成果《Multi-soft-label Guided Supervised Contrastive Learning for Gait Emotion Recognition》,,在步態(tài)情緒識(shí)別領(lǐng)域提出了高效的 Multi-soft-label Guided Supervised Contrastive Learning(MSL-SCL)框架,,為解決情緒類(lèi)別之間的模糊性和重疊性問(wèn)題提供了創(chuàng)新性解決方案。主要貢獻(xiàn)包括:

(1)傳統(tǒng)步態(tài)情緒識(shí)別方法多采用單一硬標(biāo)簽進(jìn)行分類(lèi),,忽略了情緒類(lèi)別之間的復(fù)雜關(guān)系,,導(dǎo)致分類(lèi)精度受限。MSL-SCL 框架巧妙地利用多軟標(biāo)簽信息來(lái)指導(dǎo)監(jiān)督對(duì)比學(xué)習(xí),,使模型能夠更精細(xì)地刻畫(huà)情緒步態(tài)的特征,從而有效緩解類(lèi)別模糊問(wèn)題,。該框架結(jié)合軟標(biāo)簽相似性信息和先驗(yàn)情緒步態(tài)特征,,優(yōu)化步態(tài)表示學(xué)習(xí),為步態(tài)情緒識(shí)別提供了更準(zhǔn)確的特征表示,。

(2)設(shè)計(jì)了兩種監(jiān)督對(duì)比學(xué)習(xí)模塊:Sof-SCL 和 Prior-SCL,。Sof-SCL 依據(jù)軟標(biāo)簽相似性來(lái)選擇正負(fù)樣本,并將相似性信息融入新的對(duì)比損失函數(shù),,以?xún)?yōu)化特征學(xué)習(xí),;Prior-SCL 結(jié)合領(lǐng)域知識(shí),提取步態(tài)情緒特征(如動(dòng)能,、對(duì)稱(chēng)性,、相對(duì)角度等),并作為動(dòng)態(tài)軟標(biāo)簽提供適應(yīng)性監(jiān)督,,進(jìn)一步增強(qiáng)對(duì)比學(xué)習(xí)的效果,。這種雙模塊協(xié)同作用的設(shè)計(jì),充分發(fā)揮了軟標(biāo)簽和領(lǐng)域知識(shí)的優(yōu)勢(shì),提升了模型的特征學(xué)習(xí)能力和分類(lèi)性能,。

(3)在 Emotion-Gait 數(shù)據(jù)集上的實(shí)驗(yàn)結(jié)果表明,,MSL-SCL 框架在情緒步態(tài)識(shí)別任務(wù)上超越了現(xiàn)有的 SOTA 方法,取得了 89.8% 的均值平均精度(mAP),。消融實(shí)驗(yàn)進(jìn)一步驗(yàn)證了 Sof-SCL 和 Prior-SCL 在提升識(shí)別性能方面的有效性,。這一成果為步態(tài)情緒識(shí)別領(lǐng)域的研究提供了新的技術(shù)思路和方法,有望推動(dòng)該領(lǐng)域在情感分析,、人機(jī)交互等領(lǐng)域的應(yīng)用發(fā)展,。